Gespeichert von sachs am/um

Die Entwicklung der Massenspektrometrie hat in der organischen Spurenanalytik rasante Fortschritte gemacht und ist in der Chromatographie zur wichtigsten Datenquelle geworden. Wolfgang Brodacz von der Österreichischen Agentur für Gesundheit und Ernährungssicherheit (AGES) beschreibt die bisherige Entwicklung und die Perspektiven für die Zukunft.

Obwohl man unter Kontaminanten nur jene Stoffe versteht, die dem Untersuchungsgut (Lebensmittel, Futtermittel oder die Umwelt im Allgemeinen) nicht absichtlich hinzugefügt werden (wie etwa Mykotoxine, PAKs, Dioxine und Weichmacher), gelten die folgenden Überlegungen für die organische Spurenanalytik allgemein und damit natürlich auch für Stoffe wie Pestizide und Tierarzneimittel.

Wer in die Zukunft schauen will, um die kommende Entwicklung abzuschätzen, sollte zur besseren Positionierung der Blickrichtung vorher kurz Rückschau halten. In meinem Fall hat die analytische Erfahrung Anfang der 80er-Jahre mit der Aufgabe begonnen, die Pestizid-Rückstandsanalytik von der noch weitverbreiteten Dünnschichtchromatographie zur Gaschromatographie mit gepackten Säulen zu führen. Mannsgroße Mehrkanal-GC-Monster standen in einer Reihe nebeneinander und gaben ihre analogen Signale an eine Batterie von Rollenschreibern weiter. Wer in dieser GC-Steinzeit noch Retentions zeiten und Peakhöhen mit dem Lineal vermessen musste, für den waren die ersten programmierbaren Taschenrechner schon eine Erleichterung. Und dann erst die aufkommenden Integratoren, die Peakflächen elektronisch integrieren konnten: Mein erstes Luxus-Modell beherrschte sogar BASIC. Nachdem auch ich die Programmiersprache „Beginner’s All-purpose Symbolic Instruction Code“ erlernt hatte, war der erste Schritt zur teilautomatisierten Chromatographie-Datenverarbeitung getan, gefolgt von ersten zaghaften Versuchen, diese Vorteile auch bei der Dokumentation im Sinne der Qualitätssicherung zu nutzen. Die ersten kommerziell erhältlichen Fused-Silica-Kapillarsäulen ersparten der Community das schwierige Handwerk des Selberziehens von Glaskapillaren. War die bisherige direkte On-Column-Injektion bei gepackten Säulen unproblematisch und robust, sollte sich das bei den extrem engen Kapillaren schnell ändern. Glücklich war, wer sich die Probenverschwendung bei der relativ gutmütigen Split-Injektionstechnik leisten konnte. Wir Rückstandsanalytiker konnten das jedenfalls nicht. Unterstützt vom Schweizer Kapillarsäulen-Pionier Konrad Grob konnten wir nicht nur Splitless-Injektionen fachgerecht durchführen, sondern verstanden sogar, was sich dabei im Detail abspielt, ebenso bei der noch diffizileren On-Column-Aufgabetechnik für Kapillaren.

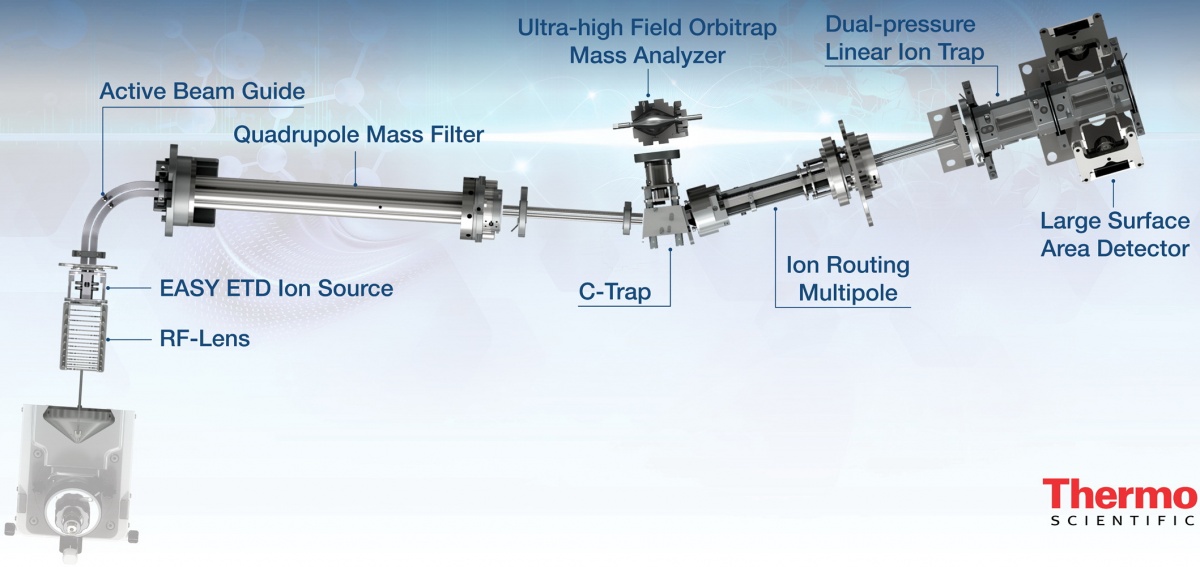

Aufbau eines modernen Tandem-MS mit Orbitrap-Technologie/Bild: Thermo Fisher Scientific

Viele Peaks

Belohnt wurden wir dafür mit einer Vervielfältigung der Peaks. Wo früher nur ein breiter „Gauß-Hügel“ auftauchte und die Welt für viele noch in Ordnung war, förderte die enorm gesteigerte Trennleistung der Kapillar-GC nun plötzlich zutage, dass dieser in Wirklichkeit aus mehreren überlagerten Peaks bestand. Und die Frage nach der Identität der neu aufgetauchten Peaks beflügelte die Analysentechnik weiter. Die richtige Antwort auf all die Fragen war sicherlich die Kopplung der GC mit massenspektrometrischen Detektoren. Mit den nun „massenweise“ anfallenden Informationen, in beiderlei Wortsinn, kam neuer Schwung in die Analytik, aber nur in jene der flüchtigen und thermisch stabilen Verbindungen.

Kritische Zeitgenossen orten dabei gewisse Parallelen zu folgender Anekdote: Ein Betrunkener sucht nachts unter einer Laterne nach seinem Autoschlüssel, den er aber schon auf dem Weg hierher verloren haben muss. Auf die Frage, warum er dann nicht diesen Weg absucht, antwortet er: „Weil hier das Licht viel besser ist.“ So kam es, dass wir den Großteil der Erkenntnisse darüber, welche Kontaminanten und Rückstände sich in unser Essen verirren und wie sie sich in der Umwelt verteilen, zu diesem Zeitpunkt in erster Linie den Massenspektrometern verdankten, die den geringen Gasfluss der GCs gut ertragen konnten.

Die Parallelwelt der Flüssigkeitschromatographie musste sich nämlich weiterhin nur mit einer vergleichsweise geringen Trennleistung und wenig selektiven Detektoren herumschlagen. Erst langsam belebten Verbesserungen des Fluoreszenzdetektors und des universell verwendeten Diodenarray-Detektors auch die Möglichkeiten im polaren Teil der analytischen Welt. Trotzdem blieb das Phänomen, das der amerikanische Psychologe Abraham Maslow so treffend beschreibt: „If all you have is a hammer, everything looks like a nail!” Und so wird das untersucht und entdeckt, was mit den gut funktionierenden und etablierten analytischen Werkzeugen fassbar ist.

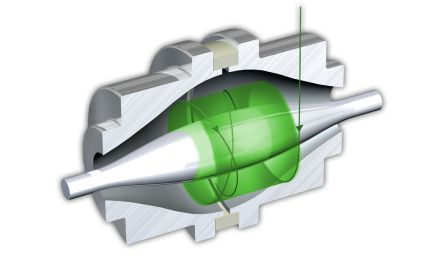

Die Orbitrap mit Darstellung des Oszillationsbereich eines Ions (grün)/Bild: Thermo Fisher Scientific

Massenspektrometer auf der Überholspur

Erst die lange erwartete Entwicklung von routinetauglichen API-Techniken (Atmospheric Pressure Ionization: ESI, APCI und APPI) brachte den Durchbruch der Massenspektrometrie auch als HPLC-Detektor. Dann kamen schon relativ rasch die Tandem-MS in Form von Triple-Quadrupolen, die noch immer als Arbeitspferde der Target-Analytik gelten. Für das Unknown-Screening (Non-Target-Analytik) wurden MS-Kombinationen mit der sehr schnell scannenden TOF-Technik (Time of Flight) entwickelt, die nun tatsächlich in der Lage sind, auch Unbekannte empfindlich ausfindig zu machen, bzw. retrospektives Data-Mining erlauben. Das heißt, man erfasst bei der Daten-Akquisition auch sogenannte „Emerging Contaminants“, von denen man noch gar nichts ahnt, sowie Metabolite und Transformationsprodukte, um sie bei Bedarf später aus der Informationsflut zu extrahieren und auszuwerten.

Bei der Target-Analytik, die meist bei gesetzlich geregelten Schadstoffen zu finden ist, wird zuerst entschieden, was interessant und/oder notwendig ist und dann gezielt darauf analysiert. Beim Non-Target-Ansatz wird durch die Full-Scan-Massenspektrometrie grundsätzlich so viel wie möglich an Informationen gesammelt und erst nachher entschieden, welchen Teil davon man näher betrachtet.

Allen Zielsetzungen gemeinsam ist grundsätzlich die Steigerung der Selektivität. Auf der chromatographischen Seite wurden dafür zweidimensionale Trennungen (2D) und die sogenannten „Comprehensive“-Techniken für GC und auch LC entwickelt, die in Folge reinere Spektren mit geringeren Interferenzen ermöglichen und bei Refokussierungen auch die Empfindlichkeit steigern können. Bei GC*GC-Peakbreiten von ca. 0,1 Sekunden kommen dann allerdings nur noch sehr schnell scannende (ab 100 Hz) TOF-Massenspektrometer infrage.

Besonders auf der Detektorseite sind seitens der MS-Geräteentwicklung enorme Selektivitätssteigerungen zu verzeichnen. Begannen die Auflösungen um das Jahr 2005 noch bei rund 5.000 FWHM (Full Width at Half Maximum), so standen wir schnell bei TOF-Auflösungen von 25.000 – 50.000 und mittels Orbitrap (FTMS) bis etwa 140.000 (H. Mol „Non-Targeted is Our Target“, The Analytical Scientist, ISSN 2051-4077, Issue #0513, 2013).

Während derzeit noch das Tandem-MS mit Triple-Quadrupol-Technik als das Gerät der Wahl für die quantitative Target-Analytik gilt, könnte sich das Blatt in Zukunft zugunsten der Full-Scan-Messungen wenden. Moderne, hochauflösende und schnell scannende Massenspektrometer haben nun auch bei der Sensitivität aufgeholt und können simultanes Unknown-Screening leisten. Sie können den Selektivitätsgewinn durch MS/MS mit dem der Hochauflösung verknüpfen.

Tripel-Quadrupol-Massenspektrometer mit schneller Datenrate werden noch sensitiver werden und ein wichtiges Instrument der quantitativen Zielkomponenten-Analytik bleiben/Bild: Shimadzu

Auflaufende Datenflut

Bei der auflaufenden Datenflut kommt der Anwender bei der Auswertung und Sichtung allerdings schnell an seine Grenzen. Der MS-Datenpool ist riesig und die Zielanalytenliste wird immer länger. Eine Automatisierung der Spektrensuche ist unbedingt erforderlich. Bei GC-EI-Massenspektren ist das schon längst üblich. Nicht zuletzt deswegen, weil dafür umfangreiche Spektrenbibliotheken (NIST:>200.000 Einträge; Wiley: >600.000 Spektren) kommerziell erhältlich sind, welche unter einheitlichen Ionisierungsbedingungen (70 eV) aufgenommen wurden. Klassische Electron-Impact-Spektren sind nur sehr wenig von der MS-Hardware abhängig und sehen daher bei vielen Geräten ähnlich aus. Das garantiert ihre universelle Verwendung in der GC-MS. Außerdem bewirkt die relativ harte Ionisierung eine fragmentreiche und damit reichhaltige Informationsbasis, die günstig ist für Spektrenvergleiche. Andererseits fehlt nicht selten der Hinweis auf das intakte Molekül in Form eines Molekülionenpeaks.

In der LC-MS gestaltet sich der Vergleich von Massespektren vielschichtiger und schon etwas problematischer. Die weichen Ionisationsarten ESI und APCI führen zu Ionen-Spezies, welche die Molekülmasse widerspiegeln, aber wenige Fragment-Informationen bereitstellen. Grundsätzlich wird die Ionisierung und Fragmentierung von der API-Methode bestimmt und ist viel mehr von technischen Details der Ionenquelle und insbesondere von den chromatographischen Randbedingungen (Eluentenzusammensetzung, Modifier etc.) abhängig. Daher sind die MS-Herstellerfirmen dazu übergegangen, für spezielle Applikationen wie etwa die Pestizidanalytik proprietäre LC-MS-Datenbanken aufzubauen und diese gemeinsam mit dem Gerätesystem als komplettes Methodenpaket anzubieten.

Das betrifft in erster Linie CID-basierende (Collision Induced Dissociation) LC-MS-Spektraldatenbanken, aber auch MS/MS-Spektren, die zwar kommerziell verfügbar sind, aber vom Umfang meist nur einen Bruchteil (NIST: ca. 82.000; Wiley: ca.12.000) der GC-MS-Electron-Impact-Spektrensammlungen bieten. LC-MS/MS-Spektrenbibliotheken holen jedoch gegenwärtig rasch auf und bewegen sich zumindest schon im vierstelligen Bereich.

Hochauflösende Massenspektrometer (HR - High Resolution) wie TOF, Q-TOF und Orbitrap präsentieren sich heute mit Massengenauigkeiten im ppm-Bereich (parts per million) und registrieren die exakte Masse (AM, Accurate Mass) eines Analyten oder dessen diagnostische Fragmente. Damit wird eine Abschätzung der elementaren Zusammensetzung und ein Vergleich mit Datenbanken wie „Chem Spider“ (rund 28 Millionen Strukturen) oder „PubChem Compound“ (etwa 20 Millionen Einträge) möglich. Die sehr genau bestimmbaren monoisotopischen Massen sind dabei der richtige Ansatz für die Suche.

Aber selbst eine Massengenauigkeit von 1ppm reicht oft nicht aus für eine eindeutige Molekülsummenformel. Die Anzahl infrage kommender Kandidaten sinkt zwar mit steigender MS-Resolution, meist sind aber noch zusätzliche Filter wie Isotopenverhältnisse, Heuristik und chemische Bindungsgesetze notwendig. Weitere Daten zum Fragmentierungsverhalten sind für eine eindeutige Identifizierung mehr als zweckmäßig. Die Krönung der Verifizierung ist letztlich der direkte Vergleich mit einem gekauften Reinstmaterial des/der Kandidaten als Kalibrierstandard (ChemSpider kann auch bei der Quellensuche helfen).

Erweiterte Möglichkeiten

Bei der Probenvorbereitung werden sich die Automatisierungsmöglichkeiten stark erweitern. Besonders in der HPLC bietet sich die Online-SPE in Form einer Säulenschaltung als kombinierte Selektivität von unterschiedlichen stationären Phasen zwischen Anreicherungssäule und analytischer Trennsäule an. Auch GPC-Varianten zur Abtrennung großer Moleküle wie etwa Lipide und TurboFlow können als generische Clean-up-Methoden den Automatisierungsgrad verbessern.

Wo offline gereinigt werden muss, werden weitere Varianten der dispersiven SPE (QuEChERS: Quick, Easy, Cheap, Effective, Rugged and Safe) entstehen und zumindest halbautomatisch ablaufen. Die reduzierten Flussraten und kurzen Laufzeiten der UHPLC sparen nicht nur kostbare, hochreine Lösungsmittel, sondern verbessern durch schärfere Peaks auch die Sensitivität bei der weitverbreiteten Elektrospray-Ionisation. Für spezielle Anwendungen wird die Chromatographie bei Micro-Flüssen (Innendurchmessern bis zu 1 mm) noch mehr Einsparungen beim Lösungsmittelverbrauch und bei der Laufzeit bringen. Gleichzeitig wird sie geringere Matrixeffekte, weniger Verschmutzung der Ionen-Optik mit Sensitivitätsgewinnen verbinden können.

Der massenspektrometrische Detektor wird sich in der LC weiter etablieren und die GC noch mehr dominieren, obwohl Anschaffung und Betrieb höhere Kosten verursachen. Besonders die LC-MS/MS stellt im Vergleich zu klassischen LC-Systemen deutlich höhere Ansprüche an die Qualifikation der Anwender. Trotzdem ist der Siegeszug der Tandem-Massenspektrometrie nicht aufzuhalten. Die GC-MS wird sich zunehmend zuerst einen Überblick im Scan (TOF oder Quadrupole im SIM/Scan) verschaffen und die Bestätigung dann vorzugsweise und hochselektiv mit GC/QQQ leisten. Die Single-Quads werden insbesondere dort GC-Marktanteile an die Tripel-Quads abgeben, wo Sensitivität und Selektivität erhöht werden müssen.

Gleiches gilt für die LC-MS, wobei die Triple-Quads in den Nischen dominant bleiben werden, in denen höchst empfindlich auf z. B. gesetzlich geregelte, taxativ aufgelistete Zielanalyten überprüft werden muss. Die Sensitivität wird sich noch wesentlich verbessern, obwohl die LC-MS-Empfindlichkeit in den letzten drei Jahrzehnten schon stärker gestiegen ist, als das Moore’sche Gesetz für Computer-Prozessoren voraussagt. Diesem Gesetz nach verdoppelt sich die Anzahl der integrierten Schaltkreiskomponenten auf einem Chip alle 18 Monate.

Die Nachweis- und Bestimmungsgrenzen werden sich primär durch noch höhere Selektivitäten verbessern lassen. Mit der differenziellen Ionenmobilitäts-Spektrometrie DMS zwischen LC und QQQ werden noch weiter gesteigerte Selektivitäten auch für isobare Verbindungen möglich sein. Dank stark verringertem Cross Talk (das sind störende „Signalverschleppungen“, die speziell bei rasch aufeinanderfolgenden MRMs von Multimethoden auftreten) können mit der schnellen Elektronik heutiger Tripel-Quads sehr kurze Zykluszeiten realisiert werden. Damit ist es möglich, mehrere Hundert Targetsubstanzen mit ihren spezifischen MRM-Übergängen überlappend in einem chromatographischen Lauf zu kontrollieren.

Neue Möglichkeiten für Unknown- Screening

Parallel dazu werden sich High Resolution und schnell scannende Massenspektrometer (TOF; Q-TOF; Orbitrap etc.) zunehmender Beliebtheit erfreuen, da sie als Mehrwert komplette und hochaufgelöste Spektren bei fast ebenbürtiger Empfindlichkeit einbringen können. Daraus werden sich neue Möglichkeiten des Unknown-Screenings entwickeln, die auf weiter ausgebauten MS-Datenbanken beruhen. EI- bzw. CID-Spektrenvergleiche werden weiterhin bei GC bzw. LC schnell und effizient anwendbar sein, aber diese Datenbasis wird (abgesehen von speziellen Applikationen) nicht immer ausreichen. Während (tw. spektrenlose) freie Struktur-Datenbanken (ChemSpider etc.) mit ihren ohnehin schon enormen Umfängen weiter vergrößern werden, sind Recherchen darin komplizierter und zeitaufwendiger.

Verbesserte Hilfestellungen durch „intelligentere“ Software werden notwendig werden, um das enorme Potenzial an Informationen, das in der (hochaufgelösten) MS-Datenflut schlummert, in Zukunft noch effizienter heben zu können. Dadurch wird man dem Ziel, alle ionisierbaren Verbindungen einer Probe mit MS- und MS/MS-Spektren zu erfassen, langsam näherkommen. In der organischen Schadstoff-Spurenanalytik wird man mit immer weiter verfeinerten Identifizierungs-Techniken wie z. B. dem Spektrenbibliotheksvergleich die Zahl falsch positiver Befunde weiter reduzieren. Überhaupt wird die Identifizierungssicherheit gegenüber der Empfindlichkeit an Bedeutung zunehmen. Hochauflösende und schnell scannende Massenspektrometer werden populärer werden, da sie bei guter Empfindlichkeit den Mehrwert von Full-Scan-Spektren einbringen.